Descubre el poder de Apache Spark

Practicar con Apache Spark y realizar proyectos por tu cuenta es fundamental si quieres convertirte en científico de datos.

Apache Spark es un potente motor de procesamiento de datos de código abierto (cualquiera puede inspeccionar, modificar y mejorar ese código).

Spark te ayuda a procesar y analizar grandes volúmenes de datos de manera muy rápida, ayudando así a las organizaciones a tomar decisiones más informadas, a resolver problemas complejos y descubrir conocimientos ocultos en los datos.

Si estás replanteándote introducirte a la ciencia de datos, esta es sin duda una de las herramientas que debes conocer.

¿Qué es Apache Spark?

Es una potente plataforma de procesamiento de datos de código abierto que ha revolucionado la forma en que se gestionan y analizan grandes volúmenes de datos.

A diferencia de las herramientas tradicionales, Spark se destaca por su velocidad y capacidad de procesar datos a gran escala en clústeres de computadoras.

¿Por qué es tan importante Apache Spark?

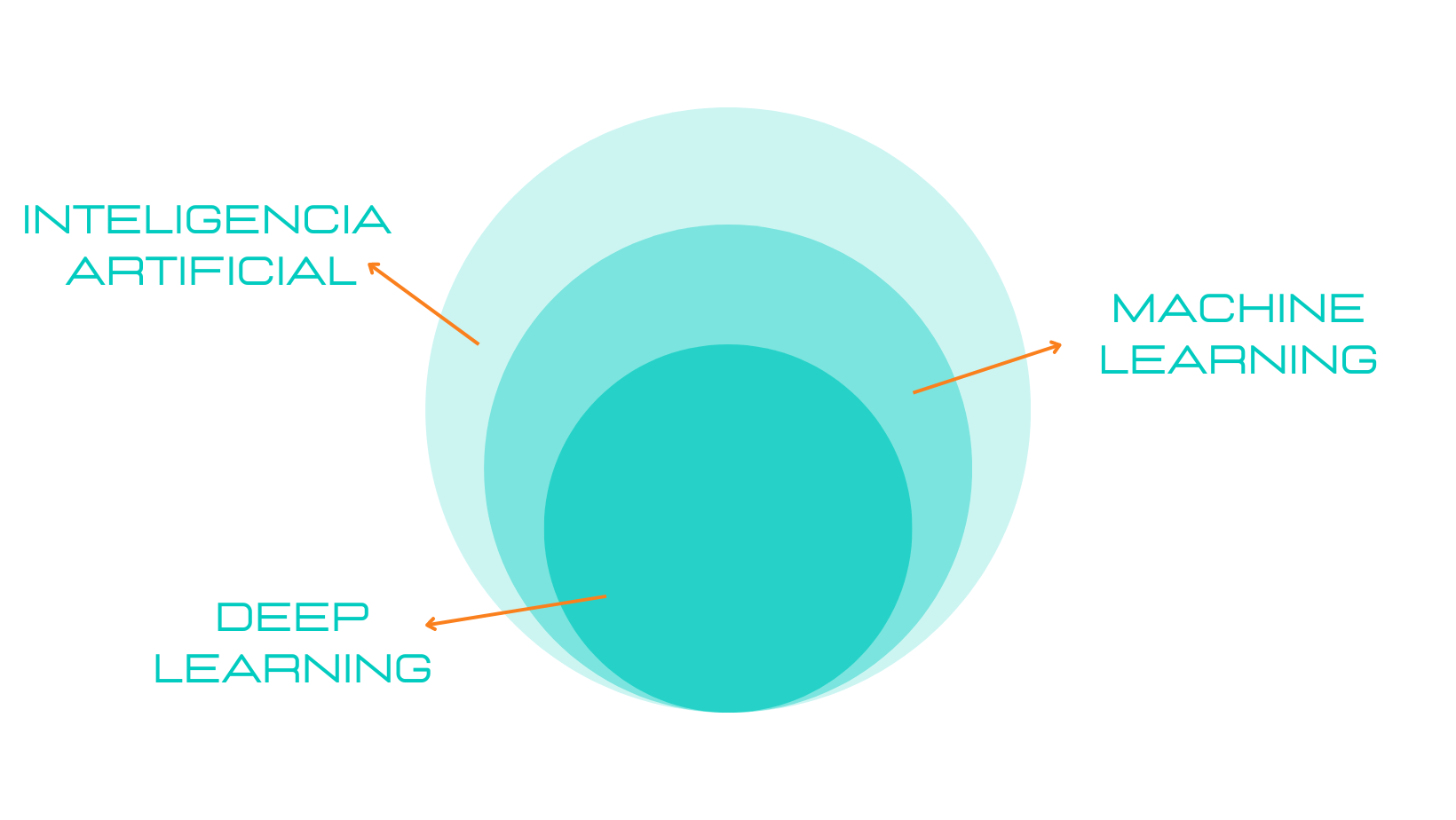

A día de hoy los datos son el activo más valioso que las empresas tienen, por eso la ciencia de datos se ha convertido en una disciplina esencial para organizaciones, empresas e investigadores.

Aquí tienes algunos de los atributos que lo hacen importante:

1. La velocidad sorprendente.

Sin duda uno de los aspectos más destacados de Apache Spark es su velocidad excepcional. Puede procesar datos hasta 100 veces más rápido que herramientas más antiguas como MapReduce. Esto significa que puedes obtener resultados y análisis en tiempo récord.

2. Escalabilidad.

Spark está diseñado para escalar horizontalmente, lo que significa que puede manejar grandes volúmenes de datos sin esfuerzo. Ya sea que estés trabajando con gigabytes o incluso petabytes de información, Spark se adapta a tus necesidades.

3. Flexibilidad.

Es compatible con varios lenguajes de programación, incluyendo Python, Java y Scala. Esto facilita que los científicos de datos escriban código en el lenguaje con el que se sientan más cómodos.

<4. Ecosistema enriquecido.

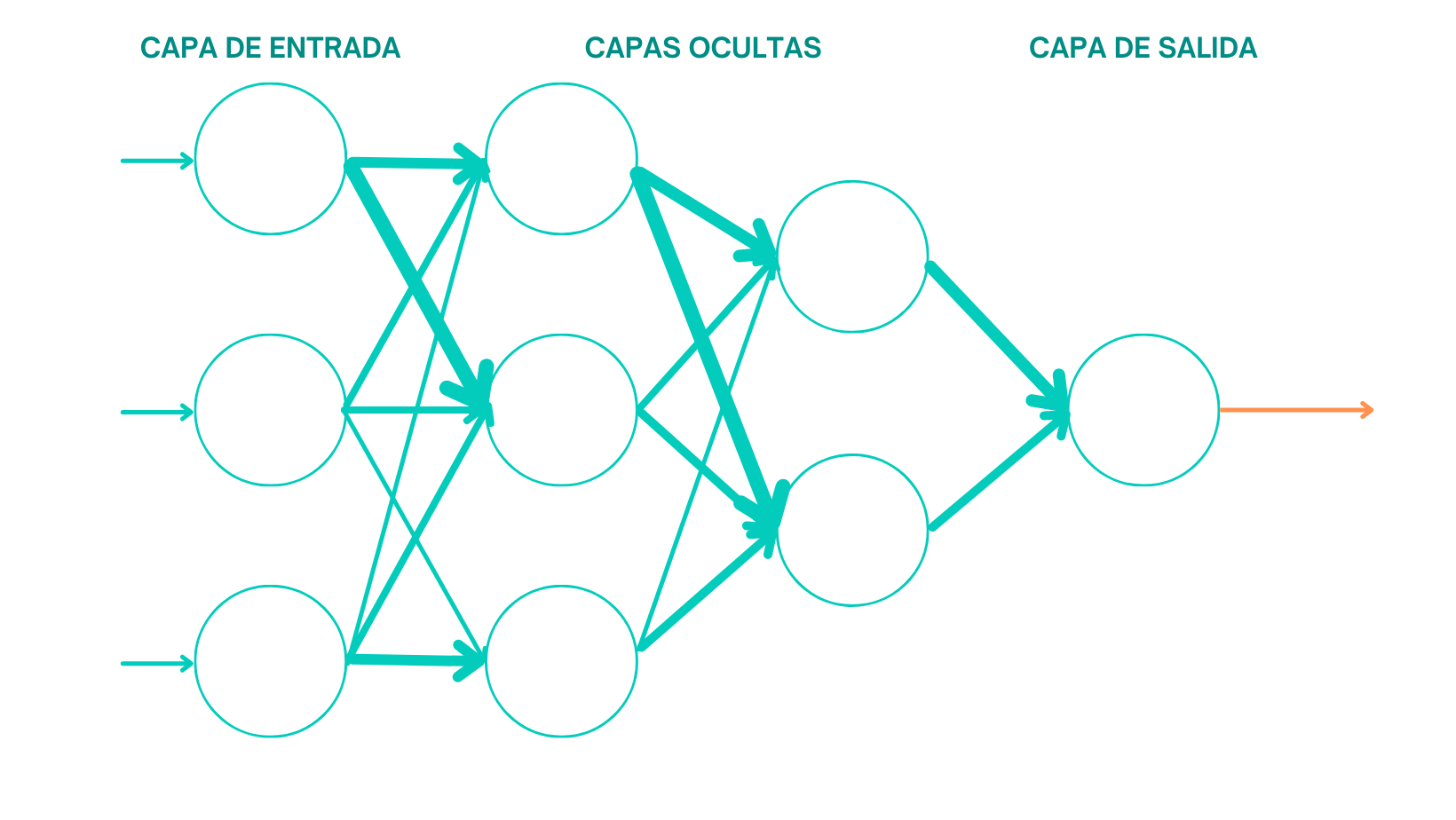

Spark cuenta con un ecosistema diversificado de bibliotecas y herramientas adicionales que simplifican tareas específicas. Esto incluye Spark SQL para consultas SQL, Spark MLlib para aprendizaje automático y Spark Streaming para el procesamiento de datos en tiempo real.

<Cómo comenzar con Apache Spark.

Aquí te dejamos unos pasos para que puedas orientarte en tu camino:

- Configuración del entorno: Antes de empezar, necesitas configurar un entorno de desarrollo. Puedes hacerlo en tu ordenador local o utilizar un clúster en la nube, como AWS o Google Cloud, para aprovechar al máximo la capacidad de escalabilidad de Spark.

- Aprender los fundamentos: Sumérgete en los conceptos fundamentales de Spark, cmo Resilient Distributed Datasets (RDDs) y Data Frames. Estos componentes son esenciales para trabajar con datos en Spark y entender su modelo de procesamiento en memoria.

- Práctica con proyectos pequeños: Comienza con proyectos simples para aplicar tus conocimientos. Carga datos de ejemplo y realiza análisis básicos para ganar experiencia práctica. Puedes explorar ejemplos de análisis de datos, procesamiento de registros o incluso implementar modelos de aprendizaje automático.

- Exploración del ecosistema: A medida que te sientas más cómodo, explora las bibliotecas y herramientas adicionales de Spark que se ajusten a tus objetivos específicos. Desde análisis de grafos hasta procesamiento de datos en tiempo real, Spark ofrece una amplia variedad de opciones para satisfacer tus necesidad.

- Aprendizaje comunitario: La comunidad de Spark es activa y colaborativa. Únete a foros en línea, grupos de estudio o participa en eventos locales o virtuales para aprender de otros profesionales y resolver tus dudas.

En conclusión:

Apache Spark es una herramienta esencial en el kit de herramientas de cualquier científico de datos.

Su velocidad, escalabilidad y flexibilidad lo hacen inestimable para el procesamiento y análisis de datos a gran escala.

A medida que emprendes tu viaje en el mundo de la ciencia de datos, Apache Spark te proporcionará las herramientas necesarias para abordar problemas complejos y tomar decisiones basadas en datos con confianza.